Über die Beta von Proxmox VE 2.0 habe ich neulich schon geschrieben. Nun habe ich mal meinen Testserver freigeräumt und eine Installation durchgeführt.

Bei dem Testserver handelt es sich um ein System von Wortmann mit folgender Konfiguration:

- CPU: Intel Xeon 3050 2x 2.16 GHz

- RAM: 6 GB DDR2 ECC

- HDD: 1×160 GB SATA II

- Mainboard: Intel S3200SH

@Martin Maurer von Proxmox: Ich weiss du liest hier mit und das freut mich sehr 😀 Korrigier mich, falls ich was falsches schreibe. Anbei die Frage, ob es denn möglich sein wird, von der Beta auf die Final zu migirieren, wenn es dann soweit ist? Und ob evtl. noVNC für den Zugriff auf die VMs eine Idee wäre?

Das Setup

Zum Setup gibt es nicht viel zu sagen. Es werden die wichtigsten Abfragen nach IP, Hostname, usw. gemacht.

Das Setup läuft flott. VMware und MS Hyper-V ist nichts dagegen.

Die ersten Schritte

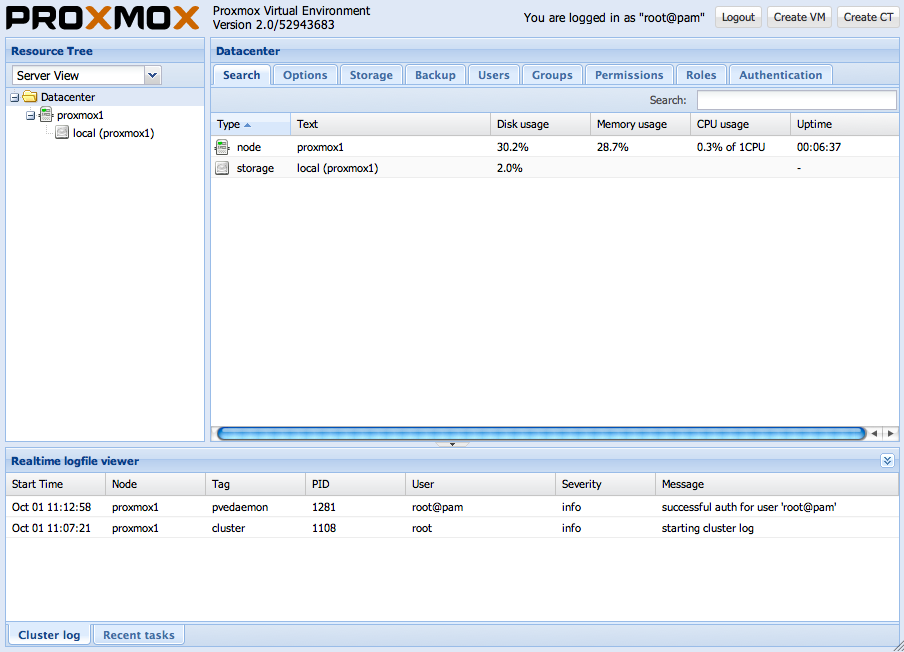

Nach der Anmeldung über einen Browser unter http://IP-ODER-HOSTNAME landet man auf der schönen neuen Oberfläche.

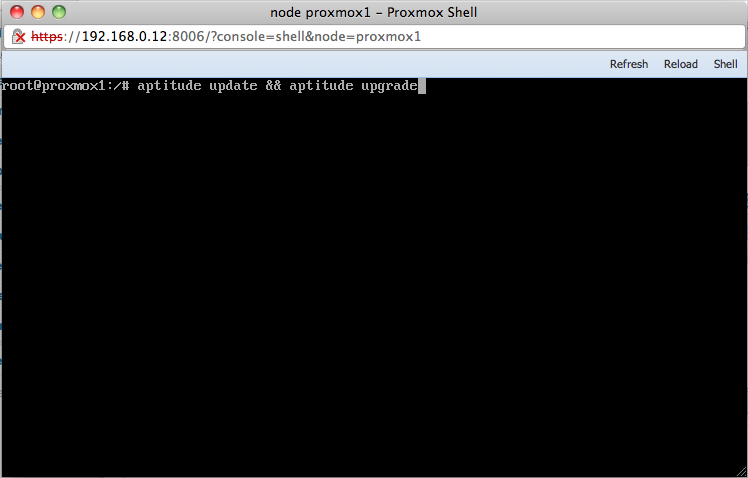

Bevor man das System produktiv nutzt, sollten die aktuellen Updates installiert werden. Dazu verwendet man entweder lokal, via SSH oder über die Web-Oberfläche (Summary – Shell) folgenden Befehl:

aptitude update && aptitude upgrade

Zum Test erstelle ich nun eine neue virtuelle Maschine für ReactOS.

Zum Test erstelle ich nun eine neue virtuelle Maschine für ReactOS.

Zuerst muss ich das aktuelle ISO-Image von ReactOS herunterladen und auf den Proxmox VE-Host hochladen. In der neuen Web-Oberfläche habe ich keine Möglichkeit gefunden, die ISO-Datei hochzuladen. Also entweder fehlt diese Option (früher war dies möglich) oder sie ist noch nicht implementiert oder ich hab’s schlichtweg übersehen. Also habe ich mit WinSCP die ISO-Datei nach “/var/lib/vz/template/iso” kopiert.

Auf “Create VM” rechts oben in der Ecke klicken.

Einen Namen für die virtuelle Maschinen vergeben und auf der nächsten Registerkarte das zu virtualisierende Betriebssystem auswählen. Da in diesem Fall ReactOS verwendet wird, nehme ich einfach mal “Windows XP”.

Auf der Registerkarte “Installation Media” wähle ich das zuvor hochgeladene ISO-Image aus.

Auf allen weiteren Registerkarten belassen ich alle Voreinstellungen wie Sie sind.

Nun kann man die virtuelle Maschine mit einem Klick auf “Start” starten und auf die Registerkarte “Console” wechseln, um die Bildschirmausgabe zu sehen.

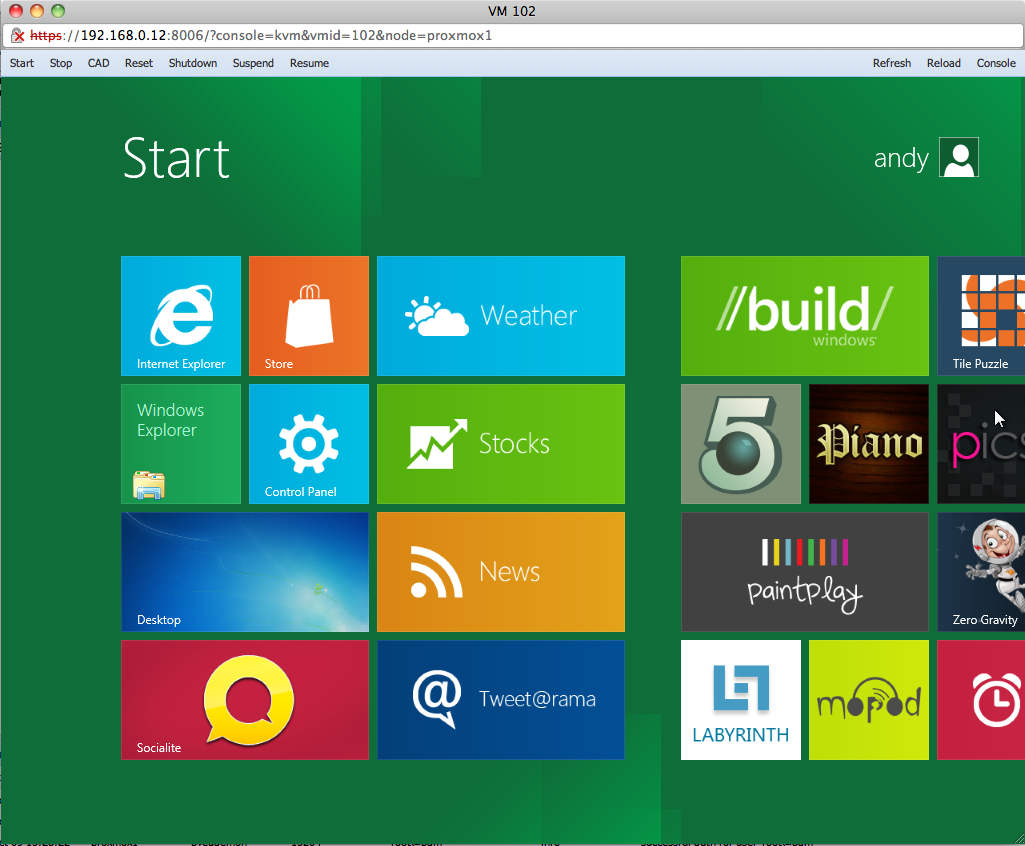

Für eine weitere virtuelle Maschine habe ich Windows 8 Developer Preview verwendet. Seltsam, die 32-bit Version bootet ins Setup und stürzt ab, aber die 64-bit Version läuft ohne Probleme. Aber immerhin, im Gegensatz zu VMware’s ESXi, ganz gleich ob 4.1 oder 5.0, läuft unter Proxmox VE bzw. KVM ohne weiteres zutun ein Windows 8. Grossartig!

Für eine weitere virtuelle Maschine habe ich Windows 8 Developer Preview verwendet. Seltsam, die 32-bit Version bootet ins Setup und stürzt ab, aber die 64-bit Version läuft ohne Probleme. Aber immerhin, im Gegensatz zu VMware’s ESXi, ganz gleich ob 4.1 oder 5.0, läuft unter Proxmox VE bzw. KVM ohne weiteres zutun ein Windows 8. Grossartig!

(Screenshots: andysblog.de)

Verheiratet, Vater von zwei Kindern, eines an der Hand, eines im Herzen. Schon immer Technik-Freund, seit 2001 in der IT tätig und seit über 15 Jahren begeisterter Blogger. Mit meiner Firma IT-Service Weber kümmern wir uns um alle IT-Belange von gewerblichen Kunden und unterstützen zusätzlich sowohl Partner als auch Kollegen.

XING

XING

Hallo!

Nachdem ich PROXMOX seit zwei Jahren immer mal wieder testweise (in der Produktivumgebung ist es XenServer) installiere, empfinde ich die als BETA deklarierte ALPHA-Version als einen Rückschritt.

Nicht mehr “smart and simple” ist diese Version 2. Die EDV-Entwickler beschreiten den üblichen Weg der Langeweile: “höher, schneller, weiter”. Die als “features” (oder “facts”) benannten neuen Möglichkeiten fallen darunter. Innovativ ist anders. Dies ist schade, da das geistige Potential hierfür sicherlich vorhanden ist.

Innovativ bei 1.x: OpenVZ und KVM im Parallelbetrieb mit Web-GUI.

Innovativ bei 2.x: ???

Logisch wäre für mich gewesen, die Softwarevirtualisierung einzubinden (Zero Install, Cameyo …).

Ich für meinen Teil finde die neue Oberfläche von der Verwaltung und der Übersicht her besser. Dann ändert sich ja auch das Cluster-Prinzip, was für solche Installationen auch von Vorteil sein dürfte. Ich für meinen Teil sehe Proxmox VE 2.0 eher als Evolution und nicht als Revolution oder Innovativ. Komplexer sollte es nicht unbedingt werden, denn dann geht es wie anderen Projekten/Produkten auch, das die Einfachheit flöten geht. Mir ist jetzt aber auch nicht ganz klar, wie man Software- bzw. Applikationsvirtualisierung integrieren soll. Da solche Dinge immer eine gewisse Infrastruktur voraussetzen. Man könnte sich allerdings vorstellen, dass das via “Virtual Appliances” lösbar wäre. Was mir persönlich halt am Besten an Lösungen wie Proxmox VE oder ArchiVista gefällt, ist die vollständige Administration via Web-Oberfläche. Man benötigt keine Client-Software, die teils nur auf bestimmten Betriebssystemen läuft.

@A. van de Valk: Ich habe gerade einen Tag bei einem Kunden mit XEN-Center gearbeitet, Proxmox 2.0 dürfte beim Einstieg noch immer einfacher sein. So war es mir und dem Kunden mit XEN-Center nicht möglich, schnell mal 1GBit-Karten oder eine Unterscheidung zwischen versioniertem bzw. wachsendem Image (qcow2 und raw analog zu KVM) zu bestimmen. Von optionalen Parametern für Prozessor-Eigenheiten ganz zu schweigen. Von da her dürfte das neue Proxmox-Interface weniger komplex bzw. deutlich flexibler bleiben als es XEN-Center und VMWare-Interface sind.

Aber, ich (und nicht nur weil ich ArchivistaVM entwickle) würde mit Dir übereingehen, dass die Komplexität bei Proxmox 2.0 im Vergleich zu Proxmox 1.x deutlich gestiegen ist. Das Einrichten einer VM ist nicht mehr in einem Fenster möglich, das Uploaden von ISO-Dateien hab ich auf Anhieb nicht gefunden. Ob eine Beta- oder Alpha-Version, ich denke das spielt keine so grosse Rolle. Eine Neuentwicklung in der Grössenordnung von Proxmox 2.0, das bedeutet viel Arbeit und irgenwann ist der Punkt da, wo das neue Werk freigegeben werden muss. Und es liegt in der Natur der Sache, dass es nicht alle toll finden. Von daher, mein grosser Respekt an die Leute von Proxmox.

Die Problematik der gestiegenen Komplexität besteht in jedem Projekt. Mehr Features bedeuten leider fast immer mehr Komplexität, bis es die Anwender/innen am Schluss überfordert. Ich habe viele Projekte mit XEN und VMware gesehen, fast alle Administratoren waren mit der Komplexität überfordert, niemand getraute sich z.B. den Stecker zu ziehen, um den Ernstfall eines Ausfalles zu simmulieren, nirgends standen Testumgebungen zur Verfügung, viele der Routine-Jobs wurden letztlich an die Lieferanten (mit der nötigen Abhängigkeit) ausgelagert. Wie gesagt, Proxmox 2.0 ist im Vergleich zu XEN und VMWare meines Erachtens nach wie vor deutlich einfacher.

Im übrigen ist es nicht ganz einfach, das Setup eines Clusters stringent hinzukrigen. In ArchivistaVM haben wir mittlerweile DRDB und auch Hochverfügbarkeit; am Interface ‘brüten’ wir noch. Eine Dokumentation gibt es noch nicht (Code liegt unter /home/cvs/archivista/jobs), es sind im Moment Perl-Skripte. Eine Dokumentation sollte es zum Vortrag am linuxday.at geben, siehe dazu http://www.linuxday.at/node/114 (das Skript wird danach sicher online verfügbar sein). Ob es uns allerdings gelingt, ein einfaches Interface hinzukriegen, wir werden sehen. Bei DRDB dachte ich am Anfang ja auch, die Perl-Skripte seien so einfach gehalten, dass die Kunden das selber ausführen würden. Bisher hat es kein Kunde selber machen wollen.

Für alle Produkte gilt, wirklich gut ist es wohl erst dann, wenn es die Anwender/innen selber erledigen können. Und ich denke, diesen Ansprch dürfte Proxmox 2.0 am Ende noch immer besser erfüllen als dies bei XEN oder VMWare der Fall ist. Immerhin ist es ja zu 100% Open Source und daher kann es m.E. flexibler eingesetzt werden als dies bei kommerziellen Produkten (alleine schon aus lizenzrechtlichen Gründen) der Fall ist.

Hallo Urs,

vielen Dank für das Riesen-Kommentar. Also in der Beta von Proxmox VE 2.0 fehlt der Web-Upload von ISO-Images tatsächlich. Ich für meinen Teil vermiss da aber auch noch ein paar andere Kleinigkeiten. Ist eben noch Beta.

Bevor jemand die folgenden Zeilen falsch verstehen könnte, Diese sind für die Allgemeinheit geschrieben:

Es stimmt in den allermeisten Fällen, je umfangreicher, desto komplexer ein Produkt oder Projekt. Mit XEN habe ich keinerlei Erfahrung, aber dafür mit VMware und Hyper-V. Da gefällt mir ArchivistaVM und Proxmox um Längen besser. Was aber im Umkehrschluss nicht bedeutet, das die anderen Produkte “schlecht” wären. Das ist wie mit der Kunst, alles eine Geschmacksfrage.

Das mit den Clustern ist so eine Sache. Ich denke, viele haben da die Komplexität von Microsoft oder anderen Produkten im Kopf. Bei VMware kann man das ja über die GUI lösen, aber auch erst dann, wenn das Shared Storage steht usw.

Von Vorteil ist bei den KVM-basierten Lösungen in der Tat die Lizenzierung als auch die Flexibilität bei der Hardware. VMware setzt ja zertifizierte Hardware voraus und Microsoft (wenn man Support haben möchte) auch. Bei XEN weiss ich es schlichtweg nicht. Aber man kann eben nicht in jedem Projekt oder bei jedem Kunden für viel Geld “fette” Server-Hardware hinstellen. Gerade in Zeiten, wo Virtualisierung auch immer häufiger in sehr kleinen Umgebungen anzutreffen ist bzw. notwendig wird (Legacy-Systeme, Stromverbrauch, Platz, …) D.h. jetzt aber nicht, das man einen Aldi-PC als VM-Host verwenden sollte. Business-PC oder Workstation-Hardware sollte das Minimum sein bei 24/7-Betrieb. Kommt eben darauf an, um was es geht. Google hat ja auch mal mit billiger Hardware angefangen.

Vielen Dank für die ausführliche Kommentierung.

Die Proxmox-Lösung ist für den weniger geübten Anwender in der ersten Stufe “einfach” gewesen. Allerdings ging es dann doch wieder an das “Innerste”. Beispiel: RAID nachträglich einrichten.

Einen Host für Virtualisierung aufsetzen ist nicht unbedingt die Schwierigkeit. Mit Opensuse und Yast ist dies recht einfach. Ebenso die Verwaltung des Hosts mit Yast (RAID einrichten …) und gleiches gilt für Virt-Manager (Problem USB passthrough an eine VM).

Mich ärgert halt, dass die Proxmox-Entwickler ihren Superansatz und ihre Superumsetzung durch die neuen features und das neue Web-GUI mehr oder minder aufgeben. Die meisten der wohl 20.000 Anwender werden kaum eine Serverfarm sondern überwiegend einen oder gar zwei Hosts am Laufen haben.

Statt die vielfältigen Anregungen dieser Anwender aufzunehmen und zu ergründen, wird das eigene Verständnis umgesetzt. Der Grundsatzsollte aber gerade die Fortsetzung des “Anderssein” = OpenSource=Openmind sein. Der Bedarf des Entwicklers ist nicht die kommerzielle Lösung sondern die sich daran knüpfende und zu vergütenden Beratungsleistungen (…Archivista…).

Was gewünscht wird zeigt gerade ganz exemplarisch und schon richtig erfolgreich OWNCLOUD.

Sinnig wäre für Proxmox 2.0 ein Web-GUI gewesen, welches sich nach dem Anmelden in Form eines Aktenschrankes auf dem Bildschirm präsentiert. Jede VM wäre ein Aktenordner, der wenn er gezogen wird, eine laufende VM auf den Bildschirm bringt oder diese erst startet. Dabei würde beim Ziehen des Aktenordners anhand der Farbe klar sein “läuft oder läuft nicht”. Ein spezieller Aktenordner PROXMOX wäre dem Administrator vorbehalten, der dann die Einstellungen oder Einrichtung vornehmen darf. Der Administrator hätte einen abweichenden Aktenordner mit Trennblättern.

Letztendlich würden die unterschiedlichen Anwender wegen der Erfahrung aus der Alltagswelt intuitiv damit umgehen können und sind nicht an diese EDV-typische Realisierung gebunden, die es erst mal wieder neu zu erlernen gilt.

Einen schönen Abend nich.

Interessanter Ansatz! Entwickler müsste man sein.

Simple in der Handhabung und Innovativ wünscht sich, glaub’ ich, jeder.

Das ein Entwickler oder Hersteller einen anderen Blick auf die Sache hat, als ein Anwender, dürfte wenig überraschen. Ich denke aber auch, das die Mädels und Jungs von Proxmox bestimmten Kundenwünschen folgen. Ich kann mir nicht vorstellen, das man aus Jucks und Dollerei ein neues Interfaces, samt neuem Cluster und x Authentifizierungsmethoden schreibt.

Aber gut, ich bleib’ bei meiner Meinung, das Geschmäcker nun mal verschieden sind. Zum Glück gibt es ja genug Alternativen.

Recht hast du auf jeden Fall, das es mittlerweile recht einfach ist, einen eigenen VM-Host aufzusetzen. Ich persönlich hätte auch nichts gegen eine einfache GUI die auf einem LAMP läuft und man ein beliebiges KVM-fähiges Linux als Unterbau hat. Klar gibt es eine Menge GUIs und Verwaltungsansätze, aber da habe ich jenseits von Proxmox und Archivista noch nichts gesehen, was wirklich einfach wäre, gerade für kleine Installationen. Eine komplette Cloud-Umgebung macht z.B. für ein 5-Personen-Büro einfach keinen Sinn.

Diese Treiber- oder RAID-Geschichte ist natürlich so eine Baustelle für sich, die nicht auf Proxmox und Archivista beschränkt ist. Das “Problem” hat man z.B. auch bei Hyper-V. Wenn man eine vollständig integrierte Lösung möchte mit wenig Aufwand bei den Treibern, dann bleibt wohl nur der Griff zu VMware und entsprechend kompatibler bzw. zertifizierter Hardware.

Da bleibt es wohl dabei: Alles hat seine Vor- und Nachteile.

Ach ja, owncloud werd’ ich mir mal anschauen. Danke für den Hinweis.

Also, das “provoziert” nun schon nochmals einen Kommentar

ArchivistaVM benötigt keine Hardware-Raids, sondern arbeitet auch mit Software-Raids. Ein eingermassen gutes Desktop-Board (ok, Limite bei 16 oder 24 GByte pro Maschine), eine AMD-CPU (Phenom), ECC-RAM und 4 bis 8 Disks (RAID10) ergeben eine sehr gute Performanz zu einem erstaunlich günstigen Preis. Solche Geräte sind durchaus ab Stange bestellbar.

Ich habe sowohl bei VMWare als auch XENServer den Eindruck gewonnen, dass im KMU-Umfeld (30-100 Mitarbeiter) zwei drei Maschinen für die VM-Instanzen und hintendran eine/zwei NetApp hängen, die im besten Fall redundant ausgelegt sind. 10GBit-Netzwerkkarten habe ich bisher nicht angetroffen, sodass die Disks mit sehr mässigem Speed à jour gehalten werden. Solche Lösungen kosten schnell mal 30000 bis 40000 EURO, ich habe aber auch Umgebungen gesehen, wo weit weit über 70000 bis 100000 Euro ausgegeben wurden. Mag sein, dass der Schweizer Markt etwas gar klotzt, aber günstig sind NetApp-Storage-Geräte wohl nicht gerade, genauso wie für die Implementierung ziemlich viel Geld in die Hände zu nehmen ist. Ich sehe da offen gestanden keine Vorteile bei VMWare oder XENServer, ich glaube zu dem Preis kriegt man bei spezialisierten OS-Firmen bereits sehr sehr viel Virtualisierung geliefert.

Aber, richtigerweise sollte eine Firma auch den Mut haben, nicht immer nur über die teuren VM-Umgebungen zu klagen, sondern Alternativen auch produktiv zu evaluieren und wenn die Leistung stimmt, diese auch einzusetzen. Umd wenn jemand ein Feature vermisst, möge er es für einen Bruchteil des Preises, der bei kommerziellen Anbietern zu zahlen wäre, realisieren lassen. Dann haben alle etwas davon.

Ui, jetzt wird’s gefährlich 😉

Stimmt, die Software-RAIDs oder “Fake-RAIDs” gibt’s auch. Und die sind (mittlerweile), besser als ihr Ruf. Das wurde ja schon mehrfach getestet und bewiesen.

Urs, du hast vollkommen recht, da gibt’s bereits gute Hardware oder Komplettsysteme ab Werk. Mit solchen Konstellationen habe ich zumindest privat auch schon gute Erfahrungen gemacht.

Bei meinen bisherigen Arbeitgebern wollte man jenseits von Hyper-V und VMware und entsprechender HP- oder IBM-Hardware nichts von wissen. Warum auch immer. Manchmal liegt das aber auch am Kunden. Ich habe einen Kunden erlebt, dem war der Name der Hersteller sehr wichtig. D.h. er fands “geil” das IBM auf seinem Serverschrank steht, das er ein Bladecenter hat usw. Ein Kollege nannte das Mal “Markenfetischischmus”. Mitunter kommt auch ein Argument wie “Wir hatten schon immer Hersteller XYZ im Einsatz”.

Der Mut etwas “Neues” zu testen fehlt manchen Firmen bzw. Verantwortlichen wohl.

Mittlerweile habe ich mit sehr kleinen Umgebungen zu tun und selbst dort ist Virtualisierung ein immer grösseres Thema. Da ist es dann schonmal notwendig, selbst für eine 5-Mitarbeiter-Firma einen VM-Host aufzusetzen.

Zum Glück bringt die Virtualisierung nicht nur Vorteile in Sachen Konsolidierungen oder den Weiterbetrieb von Legacy-Systemen, sondern auch beim Thema “Rollentrennung”. Hat man früher mitunter ziemlich viel auf einem System installiert, so kann man nun auf einer physikalischen Hardware x-virtuelle Server installieren und so z.B. Infrastruktur- und Mail-Server trennen.

Ich wüsste jetzt nicht, was an Software-RAID gefährlich sein sollte; mindestens nicht gefährlicher als an Hardware-RAID. Wir hatten die letzten zwei drei Jahre Dutzende von Hardware-Raid-Kontrollern im Einsatz (bei uns wie bei Kunden). Es gab sehr selten Probleme bei Hardware-RAID-Kontrollern, aber wenn es die gab, dann war es deftig. In der gleichen Zeit hatten wir bei Software-RAID (10) nie ein Problem. Es gab zwar letzthin dann und wann eine Platte, die den Geist aufgab. Zugegeben, dass Reparieren mit den Konsolen-Tools mach nicht Spass, aber dafür haben wir ein Skript (mdadm-repair.pl) geschrieben, läuft ganz wunderbar.

FakeRaid würde ich jetzt nicht einsetzen wollen. Nicht nur weil die ungepatchten Treiber des Kernels oft für FakeRaid-Kontroller zu alt sind (Patchen des Kernels notwendig), sondern auch weil derartige Verbünde nicht mehr einfach in einen anderen Rechner reingesteckt werden können. Dies ist einzig bei Software-RAID möglich. Und auch speedmässig bringt es nichts.

Und damit wir uns richtig verstehen, sowohl bei echten Hardware- als auch bei FakeRaid-Kontroller können die Disks als SingeDrive definiert werden. Daran anschliessend lässt sich ein Software-RAID problemlos einrichten. Ich hätte bei meinen 3Ware-Kontrollern angenommen, dass solche als Software-Raid definierten Verbünde langsamer sein müssen (der interne Cache kann ja nicht mehr angesprochen) werden, aber zu unserer Überraschung liess sich praktisch kein Unterschied in der Geschwindigkeit messen.

Software-RAIDS mit bis zu 8 Platten ergeben praktisch den nativen Speed von 4 Platten, ca. 400-420 MByte, danach haben wir (zumindest bei unseren Rechnern mit ArchivistaVM) einen gewissen Verlust, ab 16 Platten brachte es nicht mehr viel. So um die 800 MByte Durchsatz pro Sekunde erreichen wir aber durchaus. Sicher, ein excellenter RAID-Kontroller bringt noch mehr hin, aber dieser kostet dann deutlich mehr als alle Platten zusammen. Ok, auch dieses Posting wurde länger, aber sicher nicht gefährlich.

Unterm Strich ist meiner Erfahrung nach ein Software-RAID “portabler”, d.h. man kann es leichter auf ein anderes System “verpflanzen”. Stimmt, gute Hardware-Controller kosten gutes Geld. Ob man das dann auch wirklich braucht, gerade bei der nachgelagerten Anbindung, was du ja schon im vorherigen Kommentar erwähnt hast, ist dann wieder ein weiteres Thema.

Eine Frage hätte ich da allerdings noch an dich: Wie verhält es sich denn bei den Software-RAIDs und Stromausfall? Ich rate jetzt einfach mal, das kein Caching verwendet und direkt auf die Platten geschrieben wird, damit dürfte es ja dann kein Problem geben. Bei den teuren Hardware-Controllern hat man ja eine BBU als Option zur Verfügung.

Ich muss sagen, ich finde die Kommentare hier sehr hilfreich. Interessanter Erfahrungsaustausch!

P.S.: Das “Ui, jetzt wird’s gefährtlich” war eigentlich eher auf das “provozierte” Kommentar bezogen. Es wird ja hoffentlich niemand hier etwas Bierernst nehmen, oder 😉

Keine Bange, das UI geht schon ok. Und die Länge des Austauschs zeigt ja schon, dass wenn wir bei RAD-Geschichten landen, es nicht bei ein zwei Sätzen bleiben wird, in diesem Sinne Ui, ui, ui…

Est stimmt natürlich, dass bei einem Stromausfall der Cache nicht mehr auf die Platte geschrieben werden kann. Der Cache der Platte ist aber erst die halbe Miete, auch Linux bzw. die verwendeten Tools selber cachen stark. Bei einem unkontrollierten Down dürfte dies das grössere Problem darstellen.

Beispiel: Du kannst bei KVM mit oder ohne Cache arbeiten (cache=none, cache=writeback …). Seit KVM 0.12.5 bleibst Du dann aber (selbst bei einem Disk, der Dir 800 MByte Durchsatz bringen würde), bei ca. 10 bis 20 Prozent der Leistung (konkret bei ca. 59 bis 80 MByte) hängen. Wie gesagt, wir haben dieses Problem erst seit KVM 0.12.5, siehe dazu z.B.

http://us.generation-nt.com/answer/bug-594069-qemu-kvm-really-poor-write-performance-qcow2-hdd-image-help-199995311.html

http://www.ducea.com/2011/07/06/howto-improve-io-performance-for-kvm-guests/

Zusammengefasst, ohne ‘cache=writeback’ ist KVM bei schnellen Diskl-Verbünden nicht wirklich spannend (der Disk-Verbund und KVM scheinen sich zu “beissen”). Und von daher wäre dann eine USV (insbesondere in Firmen) Pflichtfach.

Und noch etwas brennt mir an dieser Stelle unter den “Fingernägeln”: Bei all unseren Systemen, bei all den Maschinen unseren Kunden und bei all jenen, welche die OS-Version von ArchivistaVM einsetzen und wir ein Feedback haben (und hier dürften die wenigsten eine USV haben), so gab es seit dem Rausnehmen von LVM2 keine Probleme mit zerschossenen RAID-Systemen mehr.

Mit LVM2 hatten wir (genauso wie Proxmox) zuweilen erhebliche Problme bei Stromausfällen. Als Beispiel sei linuxday.at 2009 angeführt. Da gab es binnen 2 Stunden mehrere Stromausfälle, bei der dritten Reorganisation des LVM2 (und erneutem Stromausfall) war das gesamte RAID dahin, obwohl wir einen Hardware-RAID-Kontroller mit BBU-Unit drinnen hatten.

Ich habe ohne LVM2 weder bei Hardware-RAID (dort gab es allenfalls sehr selten BIOS-Probleme) noch bei Software-RAID zerschossene Systeme erlebt. Und wenn ich von ich spreche, so sei damit ausgedrückt, dass dies meine Erfahrungen wiederspiegelt. Sofern jemand ganz andere Erfahrungen gemacht haben sollte, so möge er diese hier oder anderswo gerne posten.

USV sollte Pflicht sein, selbst ich hab’ in meinem kleinen Haus- und Hof-RZ eine USV. Die hat nicht mal 100 € gekostet und hält meine Systeme (je nach aktueller Last wie z.B. Backup) zwischen 10 und 20 Minuten am Laufen. Wohne hier in einem Vorort und hab’ schon des öfteren Probleme mit Stromausfällen, gerade bei schlechtem Wetter, gehabt.

Bei RAID ist es wohl auch so, wie bei vielen anderen Dingen auch. Jeder hat seine Vorlieben. Ich habe da auch schon Diskussionen zwischen Kollegen erlebt, welcher RAID-Controller/-Level nun der Bessere ist. Es ist schon verrückt manchmal.

Ich denke, besser ist es überhaupt ein RAID1, 5 oder 10 für seine wichtigen Daten zu haben, egal ob SW- oder HW-basiert. Ausserdem ist ja RAID kein Backup, das kommt auch noch dazu. Es geht schliesslich um Risikominimierung und Performance.

Letztlich bringt das Ganze nichts, wenn der Kunde es nicht bezahlen kann oder will. Für mich zählt immer die Lösung, die erfolgreich zum Ziel führt. Klar, manchmal muss man Kompromisse machen, aber Hauptsache es läuft.

Ich danke dir noch mal vielmals für die Infos und deine Zeit. Machst du eigentlich auch mal Feierabend?!

Eine abschliessende Off-Topic-Frage hätte ich da noch: Gibt es auf eurer Homepage einen Newsfeed oder Newsletter? Ich hab’ da bislang nichts gefunden, würde aber gerne up-to-date bleiben.

Es gibt einen Blog unter http://www.archivista.ch/de/pages/aktuell-blog.php (dort gibt es ca. alle vier Wochen einen neuen Eintrag).

Auch in unserem Forum lassen sich mitunter längere Antworten zu Fragen finden: http://help.archivista.ch/forum

Feierabend? Nun ja, wenn Du meine Frau fragst, dann kann ich Dir versichern, dass sie mir gerade vor ca. 30 Minuten die gleiche Frage gestellt hat? Im Ernst: Montag und Dienstag betreue ich unsere beiden Kinder, dafür arbeite ich Dienstag bis Samstag. Abends ab ca. 22:00 Uhr schreibe ich die Kommentare in meiner Freizeit. Die besteht im übrigen nicht nur aus Informatik, ich radle und wandere liebend gern über all die schönen Alpenpässe, da interessiert mich dann auch kein RAID-Kontroller mehr…

Danke für die Info.

Meine Zukünftige erinnert mich da auch immer dran, das mal Schluss sein sollte. Und ja, Informatik ist nicht alles im Leben.

Hallo Zusammen,

interessante und viele nützliche Kommentare…

Ich darf mich eben vorstellen:

Andre Köhler, IT-Fachinformatiker ANW, das ANW ändert aber nichts an der Sache, das ich unsere internen Server (SBS 2003, File-Server,Testserver) betreuen darf.

Da der SBS 2003 mit dem Exchange als Mailserver eingesetzt wird, ist es natürlich wichtig, dass dieser IMMER verfügbar ist.

Momentan ist die Hardware veraltet, der SBS läuft auf einem P4 3Ghz SingleCore mit 500GB SATA -Raid 1 und 3 GB DDR Ram.

Die anderen Server (FIleserver und Testserver) sehen nicht besser aus.

Daher bin ich auf der Suche nach neuer Hardware bzw. nach einer neuen Lösung.

Erster Plan war es die alten physikalischen Maschinen zu nutzen und VM’s mit VirtualBox und Ubuntu zu betreiben.

Dank dem VMWare Converter hab ich ja schnell aus dem laufenden Betrieb eine .vmdk erhalten, welche ich einfach in VirtualBox starten konnte und gut ist.

Problem:

– Die Windows Gastsystem laufen viel zu langsam

– DIe Hardware für den Host ist zu schlecht und der CPU kann auch keine Hardware Virtualisierung.

Somit… neue Hardware… aber… nicht so teuer und… tja irgendwie für 3 Server.

Naja.. 3 x neue 1 HE Server + 3x 1 HE als Hardwarebackup ist in der heutigen Zeit finanziell nicht machbar.

Lange rede kurzer Sinn:D ich habe mir eine Konfig vorgestellt. Dazu hätte ich gerne eure Meinung und die große Abschlussfrage:

Proxmox oder ArchivistaVM?

Hier meine Hardware, die ich ordern möchte für den VM-Host:

E3-1270 (4x 3,4 Ghz up to 3,7 Ghz durch HT 8 Cores)

16 GB DDR 1333Mhz ECC (4x4GB Riegel)

4 x 2 TB SAS-Festplatten im RAID 10 somit netto 4 TB

Hardware RAID-Controller von 3ware

Das ganze auf einem Supermicro Board und in einem 1 HE-Gehäuse.

Auf diesem Host sollen durchgehend folgende NOCH physikalische Systeme gehostet werden:

Small Business Server 2003

3 GB Ram

500 GB HDD

3,0 Ghz

Windows XP Prof.

1 GB Ram

80 GB HDD

2,8 Ghz

Windows XP Prof

3 GB

1 TB HDD

2,8 Ghz

————————

Als 4. VM soll im Bedarfsfall eine VM eingebunden werden, wenn ein physikalischer Server in die Knie geht (vmdk regelmäßig Backupen und wenn physikalischer Rechner defekt -> in VM virtualisieren und in Ruh reparieren)

SOOOO DIE FRAGEN:

Reicht die Hosthardware dafür??

und

Archivista oder Proxmox ???

Bin weder Linux erfahren, noch habe ich schonmal irgendwas mit VM’s gemacht.

Ich danke Euch.

Hallo Andre,

danke für dein Kommentar.

Ich fürchte allerdings, das eine ausgewachsene Beratung + Empfehlung durch die Glaskugel schwer realisierbar ist.

Mit VirtualBox habe ich auch schon so meine Erfahrung gemacht. Ist halt kein Hypervisor. Auf dem Desktop- oder Test-System ist es ok.

Aber zum Thema:

Drei oder vier einzelne, physikalische Server machen heutzutage in Abhängigkeit von Last und Hardware-Zugriff, d.h. muss der Server auf spezielle Hardware (Dongle, ISDN-Karten etc.) zugreifen, nicht wirklich mehr Sinn. Da stimme ich dir soweit zu.

Bei dem Mainboard würde ich auf jeden Fall darauf achten, das man in Zukunft weiter Ausbauen kann. 16 GB RAM mit Windows Server 2008 R2 als Beispiel wird schnell eng.

Ob nun Proxmox oder Archivista die für dich die bessere Lösung ist, musst du wahrscheinlich selbst herausfinden. Beide Systeme sind leicht zu bedienen, auch ohne Linux-Kenntnisse. Für beide Plattformen gibt es Service-Vereinbarungen und zertifizierte Hardware. Bei Archivista hättest du den Vorteil, das Hardware und Software aus einer Hand kommen und man im Falle eines Defekts innerhalb weniger Stunden ein Ersatz-Gerät zur Verfügung gestellt bekommt. Im Fehler- oder Problemfall ist sehr hilfreich, das Hard- und Software aus einer Hand kommen. Ferner existieren dort auch entsprechende Erfahrungswerte, wie viele VMs mit welcher Last auf welcher hauseigenen Hardware wie läuft.

Zusatzfrage: Möchtest du in Zukunft die VM-Hosts clustern?

Du solltest dir auch die Frage stellen, was für Systeme in Zukunft zu den jetzigen hinzukommen oder wie die zukünftige Auslastung aussieht.

Schon allein die Migration von SBS 2003 auf SBS 2011 ändert die Anforderungen und damit auch die Belastung des Arbeitsspeichers erheblich.

Prinzipiell kann man mit der von dir ausgesuchten Hardware schon einiges anfangen. Was evtl. spannend werden könnte sind die Treiber. Die Hardware muss von Linux (bei Archivista Debian 5.x, bei Proxmox 1.x Debian 5.x, 2.x Debian 6.x) unterstützen, bzw. Treiber für die jeweiligen Plattformen sollten zur Verfügung stehen. Sowohl Archivista als auch Proxmox fügen zusätzliche Treiber zu den Standard-Debian’s hinzu.

Kleiner Erfahrungswert am Rande: Vor ein paar Jahren wollte ich auch Linux oder VMware für ein Virtualisierungsprojekt verwenden. Es scheiterte letztlich am Treiber für den RAID-Controller, so das auf Microsoft zurückgegriffen werden musste.

Ich hoffe das hilft ein wenig.

Im Zweifelsfall weiter Fragen (gerne auch per E-Mail oder weiteres).

Gruß

Andy

Mir scheint, dass die Diskussion zu stark auf die Hardware fokussiert ist. Zugegeben meine Skripte wiederspiegeln auch nur meine persönliche Meinung, aber als Anregung für eine Evaluation von Software (KVM und generell zur Virtualisierung) könnte es dennoch Sinn ergeben, die Unterlagen durchzugehen.

http://www.linuxday.at/node/114

http://www.archivista.ch/de/media/avvm2/archivistavm-linuxday2011.pdf

http://www.freiesmagazin.de/mobil/freiesMagazin-2011-12-bilder.html#11_12_archivista

Und wenn gewisse Systeme virtualisiert werden, dann würde ich insbesondere für diese ebenfalls einen Ersatz bereithalten. D.h ich würde im scharfen produktiven Umfeld nicht nur einen VM-Server implementieren; denn auch der VM-Server selber kann down gehen — und dann kämpfst Du auf einen Schlag mit einigen Rechnern, die nicht laufen.

Am Ende wird es aber so sein, dass ein Fachgespräch (mit mehreren Anbietern!) am ehesten zum Ziel führen wird. Ich würde dabei aber nicht allzu sehr alleine auf die Hardware fixiert sein; die Hardware ist ein wichtiges Kriterium, nicht aber matchentscheidend. Ganz wichtig sind Szenarien, wie Du im Krisenfall über die Runden kommst. Zeit für Neuaufsetzen eines Server (Lizenzform), Zeit für Rückspielen Backup, Redundanz (Stichwort DRBD) etc.

Da stimme ich Urs voll und ganz zu. Sofern die Zeit gegeben ist (und das sollte sie) im Vorfeld mal Tests durchführen. Das kann z.B. in Form einer Teststellung eines Servers und das anschliessende Evaluieren der unterschiedlichen Hypervisor sein.

Ich stimme meinen Vorrednern zu. Nicht die Hardwareinvestition (trifft im Übrigen für jede Investition zu) ist entscheidend sondern das was mit ihr erreicht werden soll und wie die Betreuungskosten zu Buche schlagen (also Zeit und Geld).

Heute hat mich bei einer Proxmox 1.9 Installation der GAU ereilt. VM mit Server 2003 als Sicherung der Produktivumgebung (Xenserver) habe ich eine größere Softwareumstellung eines Anwendungspaketes einschließlich Daten durchgeführt. Lief prima durch. Beim Start des zentralen Arbeitsplatzes alles noch okay. Beim Aufruf eines Mandanten dann PENG – SQL-Datenbank gibt den Geist auf – fürchterliche Schreibaktionen auf der Festplatte – VM steht und erstmalig so schlimm, dass sich auch Proxmox nicht mehr rührte. Strom aus und innerlich schrie eine Stimme …

Strom an. Proxmox (auf getrennter Start-SSD) fährt hoch und das RAID fängt an zu resyncen. Haarsträubende Hieroglyphen auf dem Bildschirm und dazwischen irgendwelche Betriebssystemhinweise. Schon wieder diese innerliche Stimme mit “Das war´s wohl.”. Eben nicht. Irgendwann und nach gar nicht mal so langer Zeit (SW-RAID10 mit 4*500GB) war auf einmal alles wieder normal.

Bei einer reinen Windowsmaschine wäre ohne Zweifel Feierabend gewesen. Alles neu aufsetzen und ggf. Datenverlust. Hier hat das darunterliegende Basissystem Proxmox die Selbstheilung hinbekommen. Auch die “abgestürzte” VM war einfach wieder lebensfähig. Die Daten auch da. Aber selbst bei nicht reparablen Schäden hätte es keinen schmerzlichen Datenverlust gegeben – war doch nur eine (von mehreren) Datensicherung(en) und nicht das Produktivsystem. Im Produktivsystem gibt es bei sowieso nur die Lösung von Urs (DBRD, Hochverfügbarkeit …).

Mein Ungemach dauerte noch nicht mal eine Stunde. Nicht nur doppelter Boden im Betrieb sondern auch doppelter Boden bei der Datensicherung ist zwingend. Alles andere ist der bewußte Weg zum Datentot irgendwann.

Also mach ich jetzt weiter am Update meiner VM von Server 2003 auf Server 2008 und spiele dann meine portable Datensicherung ein und führe das Update ein zweites Mal aus. Und schon habe ich weitere Tests durchgeführt und sehe ob es tut. Und nächste Woche müssen meine Mitarbeiter beide VMs hinsichtlich der Anwendungsprogramme testen. Für Viele ist das scheinbar unnötiges Zeitverplempern eines Sicherheitsfanatikers oder die Spielerei eines ehemaligen IT´lers.

Nach dem Test der Mitarbeiter und nur bei Erfolg wird der Zustand der beiden VMs per snapshot oder backup eingefroren. Auch hier ist Proxmox 1.9 sehr schön – weil einfach über die GUI festlegbar. Schwieriger ist nur die Einbindung des externen Datensicherungmediums – aber die Anleitungen lesen für das Mounten eines CIFS-Laufwerkes und schon Geschichte, weil tut….

Wenn ich wirklich weiß was ich alles im Rahmen einer KOMPLETTLÖSUNG benötige, ist es nicht schwer in der Umsetzung mit Proxmox/Archivista..

Hallo Zusammen,

ich dank euch erstmal für die zahlreichen Antworten.

@Urs:

nur zur Info, über die Dokumente und den linuxday kam ich überhaupt an archivistaVM 🙂

und ich hab es bis jetzt nicht bereut.

Nun möchte ich versuchen euch einmal zu erklären wir ICH MIR…theoretisch… einen Worst Case vorgestellt habe.

Wie oben beschrieben kaufe ich einen neuen Server (der VMHOST).

Der VMHost hat 36 Mon VorAb-Austausch von allen Komponenten innerhalb von 24 h.

Heißt:

Geht mit Dienstag ne Platte kaputt hab ich Mittwoch ne neue da.

Dank RAID 10 wäre ein Plattenausfall ja kein Thema, aber was wenn der ganze RAID-Controller defekt geht?!

Für diesen Fall hab “ich mir da mal was überlegt” und ja ne Clusterlösung wäre schöner aber… fakt ist… kein Geld da. Also folgende Lösung:

Einen fetten VMHost

eine NAS

einen LapTop mit intel_VT als “Hardwarebackup”

da der LapTop sich schon in Firmenbesitz befindet, müsste dort keine Investition mehr gemacht werden.

Es sieht nun so aus, fällt der VMHost so aus das wirklich garnichts mehr geht wird der vorkonfigurierte LapTop hochgefahren und die entsprechenden Snapshots aus dem NAS eingebunden.

Der LapTop muss dann solange die VM’s “stämmen” bis der VMHOST wieder up ist. (durch Vorab Austausch also innerhalb 24 std.)

Am liebsten hätte ich natürlich 2 x VM HOST, diesen als CLuster… und fertig… aber das ist vom Preis her nicht zu machen.

Ich denke schon das ich Probleme bekomme die 2600 € für meinen geplanten VMHost durchzubekommen, da werd ich bestimmt nicht das doppelte durchkriegen “nur” für Backupsolution.

Joa… ist halt doof.. aber ich muss das beste raus machen…

Habe um 13 Uhr morgen nen Termin beim Cheffe.. um mal mit Ihm zu sprechen.. im besten Falle gibt es GARKEINE neue Hardware (ja kann auch passieren)

Ach so nachtrag:

Natürlich bin ich aktiv gerade am Testen… und zwar auf dem LapTop der später als Hardwarebackup dienen soll.

Ist ein i3 mit 4 GB RAM… habe da nun ne Kopie unseres Testservers, nen Windows XP und nen Windows 7 64 Bit virtualisiert.. alle nebeneinander running und es klappt alles toll… also ich würde sagen… für 24 Stunden (bis die Hardware für den VMHOST da ist), sollte der es schaffen die VM’s zu stämmen oder?

Klar kein “schönes” Backup Konzept aber ist halt auch Low Budget…

Wir hatten mal einen “selbstverursachenden” Crash (der Chef hat die Daten selber gelöscht) bei einem Kunden. Der Informatiker war in den Ferien; folglich musst ich notfallmässig ran. Leider waren die Testserver nicht mehr verfügbar (einer produktiv, einer defekt). Die Maschine benötigte 6 GByte RAM; es war ein Notebook vorhanden, dieses hatte 8 GByte und es war sogar ArchivistaVM aufgespielt. Dummerweise monierte der Windows-Gast, dass wir die Hardware geändert hätten (AMD zu Intel führt zu einer Neuaktivierung); wir konnten die Maschine auch nicht ans Netz hängen, da war bereits die scharfe Maschine. Ich hab dann eine neue Maschine gebaut und nach einigen Stunden hatte der Chef via Backup die Daten wieder. Daher testen, testen, und zwar vor dem Crash und immer wal wieder.

Ein Notebook muss nicht zwingend schlecht sein (zumindest nicht für einige Tage), solange die Szenarien durchgetestet wurden. Etwas skeptischer wäre ich mit der Garantie, dass die Komponenten binnen 24 Stunden ersatzbereit bereitstehen. Es kann nämlich passieren, dass die Ersatzkomponenten nicht die Lösung bringen, es kann weiter passieren, dass der Hersteller sagt, das es ein nicht zertifiziertes OS ist etc…

Die Beschreibung von A. van de Valk zeigt ja, dass es passieren kann, wenn ich persönlich daraus auch eine andere Schlussfolgerung ziehen würde (Produktivbetrieb nach hinten schieben). Meine Erfahrung bei unerklärlichen Downs ist die, dass die meisten sporadischen (unerklärlichen) Probleme wie oben beschrieben auf die RAID-Karten zurückführen sind. Beispiel: Bei einem (von ca. 20 3Ware-Raidkontrollern) gab es wiederholt über Monate etwa jede zweite Woche einen Down. Verdächtigt wurde der Rechner. Folglich tauschten wir den Rechner, nicht aber den Kontroller. Ich hätte ein gebrauchtes Exemplar einbauen müssen, der Kunde meinte, am Raid-Kontroller liege es nicht. Erst darauf (bei weiteren Downs) wurde klar, es muss der Kontroller sein; letztlich brachte ein neues BIOS die Lösung.

Schon gar nicht verwenden würde ich SSD-Platten (wir testen diese immer mal wieder) Mittlerweile hab ich sechs (von zwölf) Platten ins Jenseits befördert. Soviel konventionelle Platten hab ich in zehn Jahren nicht “zermürbt”, bei deutlich über 1000 Disks.

Für 2600 Euro kriegst Du zwei leichtgewichtige Server oder die Komponenten dreier Maschinen (wie im Skript beschrieben). Ob es sich lohnt, alles ohne Support zu machen, das muss jeder selber beurteilen. Aber bitte komme bei Problemen nicht wie unter http://support.archivista.ch/forum/read.php?6,384,384#msg-384 beschrieben zu uns; wir werden Dir kaum helfen können. Je spezieller die Hardware, je schwieriger die Lösungsuche und -findung.

Gerade wenn das Budget knapp ist, würde ich maximal die Hälfte (von mir aus zwei Drittel) für die Hardware ausgeben. Software (wie Hardware) läuft nicht einfach per se immer rund. Und früher oder später kann der Wartungsfall zuschlagen. In diesem Fälle wirst Du bei Proxmox (bei einem Supportfall) wohl günstiger fahren; aber keinen Budget-Posten zurückzustellen; dies erscheint mir sehr blauäugig. Open Source ist nicht einfach kostenfrei; es ist eine Frage, ob Du die Sourcen kriegst und daher allenfalls die Möglichkeit hast, selber nach der Lösung zu suchen. Im Idealfall sollte es sich mit Open Source günstiger machen lassen; aber dies nur, wenn ein Projekt richtig (mit Ruhe) aufgegleist wird.

Offen gestanden, ich würde (mindestens) nochmals ein Wochenende über die Sache “schlafen”, ehe ich mit einem solchen Projekt zum Chef gehen würde. Ich würde die Zeit nutzen, um über einige Jahre ein Konzept zu erstellen. Einfach die Kosten der Hardware zu kalkulieren; dies kann eigentlich nur schiefgehen. Sorry, wenn ich dies so klar sage.

Interessanter Erfahrungswert. Danke für die Info.

Software-RAID unter Proxmox? Wird aber offiziell nicht supported (funktionieren tut es aber) soweit ich weiss.

Naja, falls der RAID-Controller die Biege macht, entweder auf Austausch warten oder einen auf Ersatz hinlegen.

Laptop als Backup, hm. Kann irgendwie gehen, muss aber nicht. Vorher auf jeden Fall testen, ob Treiber für die wichtigsten Komponenten von Proxmox oder Archivista vorhanden sind. Ich denke dabei an Netzwerk und Festplatten-Controller.

Die Frage ist, liegen die VMs dann immer noch auf dem NAS oder möchtest du sie auf den Laptop kopieren?

An Performance wird da die Laptop-Festplatte zum Problem (sofern der Speicherplatz für die VMs überhaupt ausreicht).

Ganz ehrlich: Besser als nichts! Kenne genug, die haben einen single-point-of-failure und keinen Notfall-Plan.

Kurze Frage an Urs:

Unterstützt ihr ausser der eigenen Hardware auch Server von der Stange?

Falls ja, gibt es da eine Kompatibilitätsliste?

Grundsätzlich unterstützen wir gerne Hardware aller Hersteller. Wir sind aber (analog zu den DMS-Boxen) überzeugt, dass sich das erst im mittleren/oberen Sgment für den Kunden finanziell lohnt.

Grundregel:: Erwerb einer ArchivistaVM-Budget. Dabei wird keine Hardware geliefert, vielmehr stellt der Kunde die Hardware selber. Bei Problemen ist zwingend notwendig, dass wir auf die Box in der Fernwartung zugreifen können (notfalls im Setup über telnet). Wir würden bzw. können dann bei Bedarf allenfalls notwendige Treiber im Kernel entsprechend nachrüsten. Bisher erfolge dies bei einigen Projekten (z.B. Midrage-Server von IBM). Wie sowas gemacht wird, dies steht aber auch unter http://www.freiesmagazin.de/mobil/freiesMagazin-2011-12-bilder.html#11_12_archivista (zweiter Teil).

In einem Fall haben wir dem Kunden die Komponenten mitgeteilt, er hätte diese dann selber ordern und die Maschine zusammenbauen können; wir hätten ihm die Komponenten angerechnet — der Kunde zog es am Schluss allerdings vor, die ganze Box über uns zu beziehen.

Danke für die Info und gut zu wissen!

So… danke für eure ganzen Kommentare.

Und danke erst recht an Urs Pfister das er mit mir so informativ und hilfsbereit gesprochen hat!!!!

War ein sehr nettes Telefonat von knapp einer Stunde. DANKE

Nun heißt es nochmal “richtiges” Konzept erstellen.. was ich da hab ist wohl wirklich nicht “das wahre”

Hallo Andre,

evtl. kannst du uns ja auf dem laufenden Halten. Das wäre mit Sicherheit nicht uninteressant.

Gruß

Andy

Werde euch hier auf dem laufenden halten…

generell noch eine Frage zum Backup mit vzdump und dem Modus -snapshot.

Ist ein mit “snapshot” erstelltes Backup eine 1:1 Kopie der VM?

oder ist es nur ein “teilbackup” und benötigt somit die originale VM (.raw-Datei) zum wiedereinspielen.

Klar hab ich dies mal getestet…

Bei einer raw mit der Größe von 80 GB wo (laut Windows Guest noch 20 GB Frei sind) 60 GB belegt sind, ist die erstellte tgz-Datei nur 6 GB groß.

Kann das?!

Ich kann die VM als eigenständige VM wieder zurückspielen, von dahher würde ich sagen es ist eine 1:1 Kopie, aber wo sind dann die anderen GB “einfach so” hin?!

Mit den Backup-Mechanismen von Archivista und Proxmox habe ich mich noch nicht beschäftigt. Ich sichere meine VMs noch klassisch, das hängt unter anderem damit zusammen, das ein “externer” Snapshot evtl. eine Datenbank nicht konsistent sichern kann.

Was die Größe betrifft, so wird der Snapshot ja komprimiert, das kann schon grosse Unterschiede ausmachen. Ich sehe das immer bei Windows-Systemen und dem Backup mit “Drive Snapshot”, das komprimiert auch sehr gut. Möglicherweise ist das bei vzdump ähnlich “krass”.

Falls die Frage an ArchivistaVM gehen sollte, dann bitte ich um die Fragestellung in unserem Forum:

http://help.archivista.ch/forum

Danke Urs,

war ne generelle Frage zu vzdump 🙂

vzdump bei Proxmox ist nicht gleich vzdump bei archivista!